Datenpipelines sind ein grundlegender Bestandteil moderner datengesteuerter Organisationen, da sie einen effizienten und zuverlässigen Datenfluss durch das Datenökosystem einer Organisation gewährleisten. In diesem Artikel werden wir das Konzept von Datenpipelines, ihre Schlüsselkomponenten, ihre verschiedenen Anwendungsfälle und die Vorteile, die sie bieten, untersuchen. Lassen Sie uns eintauchen und entdecken, wie Pipelines Ihre datengesteuerten Abläufe revolutionieren können.

Was ist eine Datenpipeline?

Eine Datenpipeline ist eine Methode zum Transport von Daten von einem Ort zum anderen. Diese Pipelines fungieren als Datenkanal und ermöglichen eine effiziente Verarbeitung, Transformation und Bereitstellung von Daten an den gewünschten Ort. Durch die Orchestrierung dieser Prozesse optimieren sie Datenvorgänge und verbessern sie Datenqualitätsmanagement.

Entwicklung der Datenpipeline-Architektur: Von der CPU-Automatisierung zum Echtzeitfluss

Stellen Sie sich ein Szenario vor, bei dem ein System alle Aufgaben ausführt. Extraktion, Reinigung, Versöhnung – alles wird an einem Ort durchgeführt.

Dies ist keine ideale Situation, da hierfür enorme Speicher- und Rechenleistung erforderlich ist. Es ist auch sehr ineffizient. Daher wurden automatisierte Datenpipelines aufgebaut, um Daten von verschiedenen Orten und in unterschiedlichen Phasen zu verbinden.

Datenpipelines haben sich in den letzten vier Jahrzehnten weiterentwickelt. Anfangs waren sie technisch gesehen nicht existent. Datenanalysten mussten Daten manuell von der Quelle zum Ziel übertragen. Früher wurden die Daten einmal am Tag stapelweise verschoben, was die Zeit bis zur Einsicht verkürzte.

Im Laufe der Zeit wurden diese Pipelines flexibler und erleichterten die Übertragung von Daten von Cloud-Quellen zu Cloud-Zielen wie AWS und Schneeflocke. Im heutigen Kontext konzentrieren sie sich auf die effiziente Erfassung von Daten, insbesondere Echtzeitdaten, und auf die Notwendigkeit von Automatisierung und Orchestrierung.

Arten von Datenpipelines

Es gibt verschiedene Arten von Datenpipelines, die jeweils einem bestimmten Zweck dienen:

- Batch-Pipelines: Diese Pipelines verarbeiten Daten in großen Mengen in geplanten Abständen. Sie eignen sich ideal für die Analyse historischer Daten, Offline-Berichte und stapelorientierte Aufgaben.

- Echtzeit-Pipelines: Diese Pipelines verarbeiten Daten nahezu in Echtzeit oder mit geringer Latenz. Sie sind für das Streaming von Datenquellen wie Sensoren, Protokollen oder Social-Media-Feeds konzipiert. Echtzeit-Pipelines ermöglichen eine sofortige Analyse und Reaktion auf aufkommende Trends, Anomalien oder Ereignisse und sind daher für Anwendungen wie Betrugserkennung, Echtzeitanalysen und Überwachungssysteme von entscheidender Bedeutung.

- ETL-Pipelines: ETL-Pipelines sind weit verbreitet für Datenintegration und Data Warehousing. Dabei werden Daten aus verschiedenen Quellen extrahiert, in ein einheitliches Format umgewandelt und in ein Zielsystem geladen. ETL-Pipelines sind in der Regel stapelorientiert, können jedoch für eine dynamischere Datenverarbeitung durch Echtzeitkomponenten erweitert werden.

- ELT-Pipelines: ELT-Pipelines (Extrahieren, Laden, Transformieren) ähneln ETL-Pipelines, weisen jedoch eine andere Schrittfolge auf. In ELTDabei werden die Daten zunächst in ein Zielsystem geladen, z.B Daten See or Data Warehouse, und dann nach Bedarf transformiert. Dieser Ansatz nutzt die Rechenleistung und Skalierbarkeit moderner Speichersysteme und ermöglicht die direkte Durchführung von Transformationen an den geladenen Daten.

- Ereignisgesteuerte Pipelines: Diese Pipelines werden durch bestimmte Ereignisse oder Auslöser ausgelöst, beispielsweise durch den Eingang neuer Daten oder Systemereignisse. Sie ermöglichen eine Datenverarbeitung in Echtzeit oder nahezu in Echtzeit und werden häufig in der komplexen Ereignisverarbeitung, IoT-Anwendungen und ereignisbasierten Architekturen eingesetzt.

Datenpipeline vs. ETL

Diese beiden Begriffe können Menschen oft verwirren. Der Hauptunterschied zwischen einer Datenpipeline und einer ETL-Pipeline besteht darin, dass eine ETL-Pipeline eine Teilmenge von Datenpipelines ist. Datenpipelines sind ein allgemeiner Begriff für das Verschieben von Daten von einer Quelle zu einem Ziel in einem strukturierten Fluss. ETL-Pipelines sind eine spezielle Art von Pipeline zum Transformieren und Laden von Daten.

Hier sind die Grundlagen Unterschiede zwischen Datenpipelines und ETL

Datenpipeline:

- Datenbewegung und -integration: Datenpipelines konzentrieren sich in erster Linie darauf, Daten von einem System in ein anderes zu verschieben und Daten aus verschiedenen Quellen zu integrieren. Sie ermöglichen die effiziente und zeitnahe Übertragung von Daten zwischen Systemen oder Diensten.

- Flexibilität: Sie können im Vergleich zu flexibler und vielseitiger sein ETL Prozesse. Sie werden je nach Anwendungsfall häufig für Echtzeit-Datenstreaming, Stapelverarbeitung oder beides verwendet.

- Streaming-Daten: Datenpipelines eignen sich gut für die Verarbeitung von Streaming-Daten, beispielsweise Daten, die kontinuierlich von IoT-Geräten, sozialen Medien oder Webanwendungen generiert werden.

- Verarbeitung nahezu in Echtzeit: Datenpipelines eignen sich besser für Anwendungen, die aktuelle Erkenntnisse erfordern, da sie Daten nahezu in Echtzeit verarbeiten und bereitstellen können

- Anwendungsfälle: Zu den häufigsten Anwendungsfällen für Datenpipelines gehören Protokoll- und Ereignisverarbeitung, Echtzeitanalysen, Datenreplikation und Datensynchronisierung.

ETL (Extrahieren, Transformieren, Laden):

- Strukturierter Prozess: ETL-Prozesse folgen einer strukturierten Abfolge von Aufgaben: Datenextraktion aus Quellsystemen, Datenumwandlung um Geschäftsanforderungen zu erfüllen und Daten in ein Ziel-Repository (häufig ein Data Warehouse) zu laden.

- Stapelverarbeitung: ETL-Prozesse sind in der Regel für die Stapelverarbeitung konzipiert, bei der Daten über einen bestimmten Zeitraum (z. B. täglich oder stündlich) gesammelt und transformiert werden, bevor sie in das Zielsystem geladen werden.

- Komplexe Transformationen: ETL ist die richtige Wahl, wenn Sie komplexe Datentransformationen wie Aggregationen durchführen müssen. Datenbereinigung und Datumsanreicherung

- Datenspeicherung: Sie sollten sich bei Bedarf für ETL-Prozesse entscheiden Daten konsolidieren aus mehreren Quellen und transformieren Sie sie zur Unterstützung von Business Intelligence und Reporting.

- Historische Analyse: ETL-Prozesse eignen sich für die Analyse und Berichterstattung historischer Daten, wobei Daten in einem strukturierten Format gespeichert werden, das für Abfragen und Analysen optimiert ist.

Gemeinsamkeiten:

- Datentransformation: Sowohl Datenpipelines als auch ETL-Prozesse beinhalten Datentransformationen, aber die Komplexität und der Zeitpunkt dieser Transformationen unterscheiden sich.

- Datenqualität: Gewährleisten Datenqualität ist sowohl in Datenpipelines als auch in ETL-Prozessen wichtig.

- Überwachung und Protokollierung: Für die Nachverfolgung sind in beiden Fällen Überwachungs- und Protokollierungsfunktionen erforderlich Datenbewegung, Transformation und Fehler.

Aufbau einer Datenpipeline – Sechs Haupt S.Etagen

Der Aufbau eines effizienten Systems zur Konsolidierung von Daten erfordert eine sorgfältige Planung und Einrichtung. Der Prozess umfasst typischerweise sechs Hauptphasen:

- Identifizieren von Datenquellen: Der erste Schritt besteht darin, die Datenquellen zu identifizieren und zu verstehen. Dies können Datenbanken sein, APIs, Dateien, Data Lakes, externe Dienste oder IoT-Geräte. Bestimmen Sie das Format, die Struktur und den Speicherort der Daten.

- Datum Integration: Extrahieren und kombinieren Sie Daten aus den identifizierten Quellen mithilfe von Datenkonnektoren. Dies kann das Abfragen von Datenbanken, das Abrufen von Daten von APIs, das Lesen von Dateien oder das Erfassen von Streaming-Daten umfassen.

- Datentransformation: Transformieren und bereinigen Sie die Daten nach dem Extrahieren, um ihre Qualität und Konsistenz sicherzustellen. Die Datentransformation umfasst Aufgaben wie Datenreinigung, Filtern, Aggregieren, Zusammenführen und Anreichern. In dieser Phase wird sichergestellt, dass die Daten das gewünschte Format und die gewünschte Struktur für die Analyse und Nutzung aufweisen.

- Laden von Daten: Laden Sie die Daten nach der Transformation in das Zielsystem oder Repository zur Speicherung, Analyse oder Weiterverarbeitung. Während der Ladephase übertragen die Pipelines die transformierten Daten an Data Warehouses, Data Lakes oder andere Speicherlösungen. Dadurch können Endbenutzer oder nachgelagerte Anwendungen effektiv auf die Daten zugreifen und diese nutzen.

- Automatisierung und Zeitplanung: Richten Sie Automatisierungs- und Planungsmechanismen ein, um die Datenpipeline in regelmäßigen Abständen oder als Reaktion auf bestimmte Ereignisse auszuführen. Die Automatisierung minimiert manuelle Eingriffe und stellt sicher, dass die Daten immer aktuell sind.

- Überwachung und Bewertung: Robust umsetzen Überwachung und Metriken um den Zustand und die Leistung der Datenarchitektur zu verfolgen. Richten Sie Benachrichtigungen ein, um Sie über Probleme oder Anomalien zu informieren, die Ihrer Aufmerksamkeit bedürfen. Diese Phase hilft bei der Optimierung Ihrer Datenpipelines, um maximale Effizienz beim Verschieben von Daten sicherzustellen.

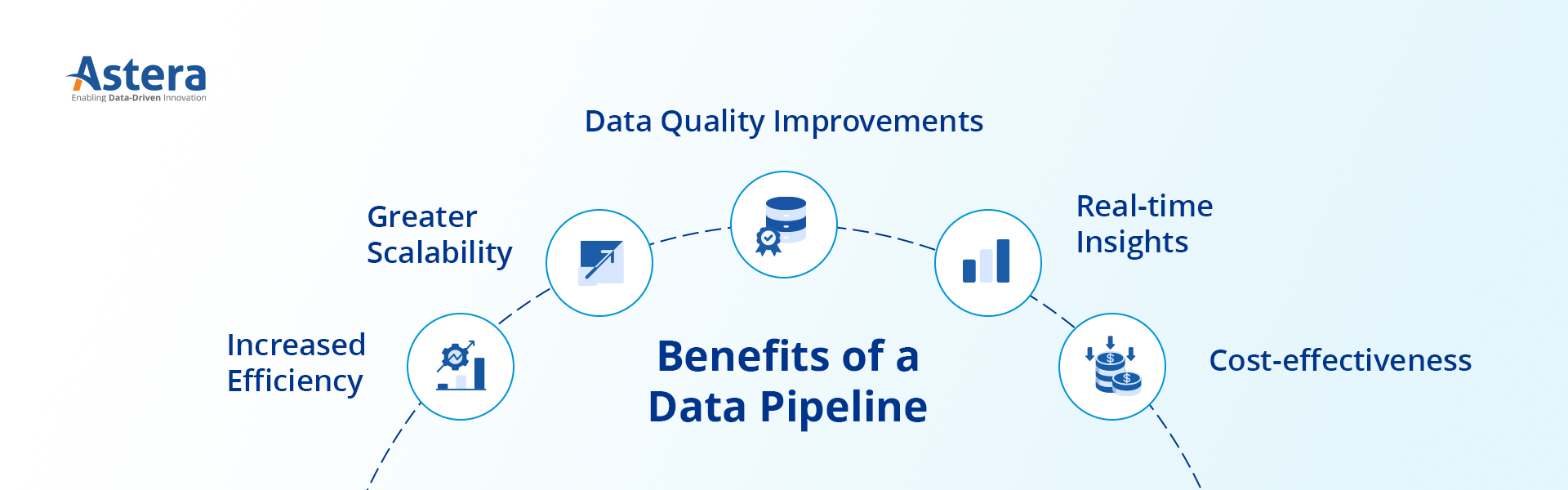

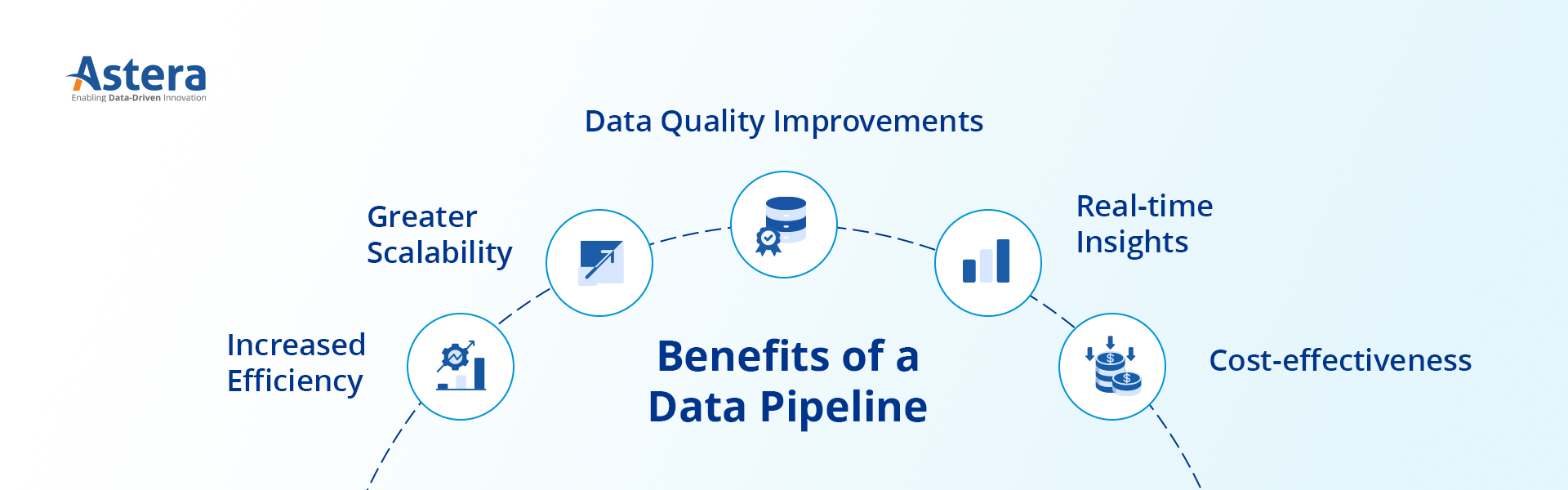

Vorteile einer Datenpipeline

Vereinfacht ausgedrückt ermöglicht die Datenpipeline Unternehmen, das volle Potenzial ihrer Datenbestände auszuschöpfen. Hier sind einige ihrer wichtigsten Vorteile:

-

Erhöhte Effizienz

Datenpipelines automatisieren Datenabläufe, reduzieren den manuellen Aufwand und steigern die Gesamteffizienz bei der Datenverarbeitung. Durch die Rationalisierung von Datenvorgängen können Unternehmen die Ressourcennutzung optimieren und die mit der manuellen Datenverarbeitung verbundenen Kosten minimieren.

-

Größere Skalierbarkeit

Sie können große Datenmengen verarbeiten und ermöglichen es Unternehmen, ihre Abläufe entsprechend ihrem wachsenden Datenbedarf zu skalieren. Durch die Einführung einer skalierbaren Architektur können Unternehmen steigenden Datenanforderungen gerecht werden, ohne die Leistung zu beeinträchtigen.

-

Datenqualität Verbesserungen

Durch Datenbereinigungs- und Transformationsprozesse verbessern sie die Datenqualität und gewährleisten Genauigkeit bei der Analyse und Entscheidungsfindung. Durch die Einhaltung hoher Datenqualitätsstandards können sich Unternehmen auf vertrauenswürdige Erkenntnisse verlassen, um ihre Geschäftsaktivitäten voranzutreiben.

-

Echtzeit-Einblicke

Echtzeitdaten ermöglichen es Unternehmen, aktuelle Informationen für sofortiges Handeln zu erhalten. Durch die Nutzung zeitnaher Dateneinblicke können Unternehmen agile und proaktive Entscheidungen treffen und sich unter dynamischen Marktbedingungen einen Wettbewerbsvorteil verschaffen.

-

Kosteneffizienz

Sie optimieren die Ressourcennutzung und minimieren die Kosten, die mit der manuellen Datenverarbeitung und -verarbeitung verbunden sind. Durch die Reduzierung des Zeit- und Arbeitsaufwands für Datenoperationen können Unternehmen Ressourcen effizient zuweisen und Kosteneffizienz erzielen.

Verwendungsmöglichkeiten einer Datenpipeline: Häufige Anwendungen zur Datennutzung

Datenpipelines erfüllen branchenübergreifend eine Vielzahl von Zwecken und ermöglichen Unternehmen zeitnahe Erkenntnisse und datengesteuerte Entscheidungen. Sie werden in zahlreichen Branchen eingesetzt, um die Effizienz des Datenflusses innerhalb von Organisationen zu verbessern.

Zum Beispiel im FinanzsektorSie helfen bei der Integration von Aktienkursen und Transaktionsaufzeichnungen und ermöglichen es Finanzinstituten, das Risikomanagement zu verbessern, Betrug zu erkennen und die Einhaltung gesetzlicher Vorschriften sicherzustellen.

Im Gesundheitswesen integrieren Pipelines elektronische Gesundheitsakten und Laborergebnisse und tragen so zu einer verbesserten Patientenüberwachung, Bevölkerungsgesundheitsverwaltung und klinischen Forschung bei.

Im Einzelhandels- und E-Commerce-Bereich integrieren sie Kundendaten von E-Commerce-Plattformen und Point-of-Sale-Systemen und ermöglichen so eine effektive Bestandsverwaltung, Kundensegmentierung und personalisierte Marketingstrategien.

Einige allgemeinere Anwendungsfälle:

-

Echtzeitanalysen

Datenpipelines ermöglichen es Unternehmen, Daten in Echtzeit zu sammeln, zu verarbeiten und zu analysieren. Durch die Nutzung der Leistungsfähigkeit von Echtzeitanalysen können Unternehmen zeitnahe Entscheidungen treffen, schnell auf Marktveränderungen reagieren und sich einen Wettbewerbsvorteil verschaffen.

-

Datenintegration

Datenpipelines konsolidieren Daten mithilfe von Datenkonnektoren aus verschiedenen Quellen, einschließlich Datenbanken, APIs und Plattformen von Drittanbietern, in einem einheitlichen Format für Analyse und Berichterstellung. Diese Integration ermöglicht es Unternehmen, das volle Potenzial ihrer Datenbestände auszuschöpfen und einen ganzheitlichen Überblick über ihre Abläufe zu erhalten.

-

Datenmigration

Sie ermöglichen einen reibungslosen und effizienten Betrieb Datenmigration von Legacy-Systemen bis hin zu moderner Infrastruktur. Durch die Gewährleistung eines nahtlosen Übergangs ohne Unterbrechung können Unternehmen fortschrittliche Technologien nutzen und Innovationen vorantreiben.

-

Maschinelles Lernen und KI

Sie bieten einen nahtlosen Datenfluss für das Training von Modellen für maschinelles Lernen. Dies ermöglicht es Unternehmen, prädiktive Analysen zu entwickeln, Prozesse zu automatisieren und das Potenzial künstlicher Intelligenz zu nutzen, um ihr Geschäft voranzutreiben.

-

Geschäftsanalytik

Datenpipelines unterstützen die Extraktion und Transformation von Daten, um aussagekräftige Erkenntnisse zu generieren. Durch die Nutzung der Leistungsfähigkeit von Business Intelligence können Unternehmen datengesteuerte Entscheidungen treffen, Trends erkennen und effektive Strategien entwickeln.

Arbeiten mit Datenpipeline-Tools

Datenpipeline-Tools erleichtern den Aufbau von Datenpipelines, da sie heutzutage größtenteils ohne Code auskommen und eine visuelle Schnittstelle bieten. Die Wahl des richtigen Tools ist jedoch für jedes Unternehmen eine entscheidende Entscheidung. Das richtige Tool sollte Konnektivität zu einer breiten Palette von Datenbanken, APIs, Cloud-Zielen usw. bieten. Es sollte auch Unterstützung für Echtzeit-Datenintegration sowie ETL und ELT bieten. Ein ideales Werkzeug sollte skalierbar sein; Es sollte in der Lage sein, wachsende Datenmengen und gleichzeitige Benutzer zu bewältigen. Es sollte eine horizontale Skalierung ermöglichen, um mehr Knoten und eine erhöhte Benutzernachfrage zu bewältigen.

Hier sind einige Tools, die Sie in Betracht ziehen können:

- Astera Centerprise: Ein No-Code Datenmanagement-Lösung Damit können Sie in wenigen Minuten Datenpipelines der Enterprise-Klasse erstellen. Es ermöglicht Ihnen, ETL- und ELT-Pipelines über eine einfache Drag-and-Drop-Oberfläche zu erstellen und zu planen. Es unterstützt außerdem umfassende Konnektivität zu branchenführenden Datenbanken und Lagern. Darüber hinaus können Sie alle Abläufe automatisieren und Daten in Echtzeit überwachen und die Vorteile erweiterter integrierter Transformationen, Datenqualität, Versionskontrolle und Sicherheitsfunktionen nutzen. Es handelt sich um ein leistungsstarkes Tool, das unter Berücksichtigung der Bedürfnisse sowohl technischer als auch nichttechnischer Benutzer entwickelt wurde.

- Daten: Dataddo ist ein cloudbasiertes, codefreies Tool zum Erstellen von ETL-Pipelines. Es lässt sich nahtlos mit Ihrem vorhandenen Stack verbinden und unterstützt mehrere Anschlüsse.

- Informatik: Informatica ist ein weiteres Tool der Unternehmensklasse zum Aufbau von Datenpipelines. Das Tool ist mit umfassenden Funktionen wie einer Vielzahl von Konnektivitätsoptionen und verschiedenen Datenquellen ausgestattet. Informatica ist jedoch etwas teurer als andere Tools auf dem Markt.

- Hevodaten: Hevodata verfügt über eine benutzerfreundliche grafische Oberfläche, die den Aufbau von Datenpipelines erleichtert. Das Tool unterstützt benutzerfreundliche Integrationen zwischen Datenbanken, SaaS-Anwendungen und Cloud-Speicher. Das Besondere an hevodata ist die volumenbasierte Preisgestaltung, die es ideal für kleine und mittlere Unternehmen macht.

Neue Trends in Datenpipelines

Über die üblichen Anwendungsfälle hinaus gibt es für Datenpipelines Anwendungen in verschiedenen fortgeschrittenen Szenarien und aufkommenden Trends:

- Echtzeit-Personalisierung: Pipelines ermöglichen eine Personalisierung in Echtzeit, indem sie Benutzerverhaltensdaten analysieren und personalisierte Inhalte oder Empfehlungen in Echtzeit bereitstellen.

- Datenverarbeitung im Internet der Dinge (IoT): Mit dem Aufkommen von IoT-Geräten wird die Datenintegration genutzt, um riesige Mengen von Sensordaten, die von IoT-Geräten generiert werden, zu erfassen, zu verarbeiten und zu analysieren, was Einblicke in Echtzeit und Automatisierung ermöglicht.

- Datennetz: Das Data-Mesh-Konzept dezentralisiert sie und etabliert eine domänenorientierte Self-Service-Dateninfrastruktur. Es fördert Dateneigentum, Autonomie und einfachen Zugriff auf Daten und führt zu einer verbesserten Skalierbarkeit und Agilität bei der Datenverarbeitung.

- Föderiertes Lernen: Sie unterstützen föderierte Lernansätze, bei denen maschinelle Lernmodelle gemeinsam auf verteilten Datenquellen trainiert werden und gleichzeitig Datenschutz und Sicherheit gewahrt bleiben.

- Erklärbare KI: Sie können Techniken zur Generierung erklärbarer KI-Modelle integrieren und so für Transparenz und Interpretierbarkeit in komplexen Modellen des maschinellen Lernens sorgen.

Zusammenfassung

Zusammenfassend lässt sich sagen, dass Datenpipelines in der modernen Landschaft eine wichtige Rolle spielen und eine effiziente Datenverarbeitung, -integration und -analyse ermöglichen. Durch die Nutzung der Leistungsfähigkeit von Pipelines können Unternehmen die Entscheidungsfindung verbessern, die betriebliche Effizienz verbessern und wertvolle Erkenntnisse aus ihren Daten gewinnen.

Datenintegrationstools Gefällt mir Astera Centerprise Vereinfachen Sie die Erstellung von End-to-End-Datenflüssen. Mit seiner benutzerfreundlichen Oberfläche, vorgefertigten Anschlüssen und umfassenden Funktionen Centerprise Optimiert den Prozess des Aufbaus und der Verwaltung von Pipelines, sorgt für eine nahtlose Datenbewegung und liefert umsetzbare Erkenntnisse für Unternehmen.