Hoy en día, las organizaciones dependen en gran medida de los datos para predecir tendencias, pronosticar, planificar requisitos futuros, comprender a los consumidores y tomar decisiones comerciales. Para realizar estas tareas, es esencial obtener acceso rápido a los datos empresariales en un solo lugar. Aquí es donde la ingesta de datos resulta útil. ¿Pero, qué es esto?

Ingestión de datos

¿Qué es la ingestión de datos?

La ingestión de datos es el proceso de obtener e importar datos de diversas fuentes y transferirlos a una base de datos de destino donde pueden almacenarse y analizarse. Dependiendo de las necesidades y la infraestructura del negocio, este movimiento de datos puede ser por lotes o en tiempo real.

El sistema de destino puede ser una base de datos, almacenamiento de datos, datos, data mart, etc. Por otro lado, las fuentes de datos podrían incluir hojas de cálculo, extracción o scrapping de datos web, aplicaciones internas y datos SaaS.

Los datos empresariales suelen almacenarse en múltiples fuentes y formatos. Por ejemplo, los datos de ventas pueden estar en Salesforce, información de productos de la tienda DBMS relacional, etc. Como estos datos se originan en diferentes ubicaciones, los analistas deben limpiarlos y convertirlos para analizarlos y tomar decisiones rápidamente. Las herramientas de ingesta de datos son de gran utilidad en tales escenarios.

Pregunta frecuente 1: Ingestión de datos versus integración de datos: ¿Cuál es la diferencia?

A primera vista, ambos conceptos parecen similares. Sin embargo, la ingesta de datos y la integración de datos no son lo mismo. La ingestión de datos consiste en recopilar y mover datos a un sistema de destino para su uso o almacenamiento inmediato. La integración de datos, por otro lado, implica unificar datos dispersos en sistemas y aplicaciones dispares en un repositorio central, creando una vista única e integral para informes y análisis.

Pregunta frecuente 2: ¿Cuál es la diferencia entre la ingesta de datos y ETL/ELT?

Nuevamente, la ingesta de datos implica recopilar datos sin procesar y trasladarlos a un sistema sin transformación. Ocurre al inicio del proceso de datos y se centra en la importación de datos a un área de preparación. Por el contrario, ETL y ELT utilizan diferentes técnicas para integrar datos: incluyen extracción, transformación y carga de datos, y la secuencia de los pasos depende de si el método utilizado fue ETL o ELT. La transformación de datos puede consistir en limpiar, enriquecer y reestructurar datos para prepararlos para su análisis o almacenamiento.

Relacionado: Aprende cómo La ingesta de datos difiere de ETL.

Tipos de ingesta de datos

La ingesta de datos puede ocurrir de diferentes maneras, como en tiempo real, en lotes o una combinación de ambos (conocida como arquitectura lambda), según los requisitos comerciales.

Veamos formas de realizarlo con más detalle.

La ingesta de datos en tiempo real, también conocida como transmisión de datos, es útil cuando los datos recopilados son extremadamente urgentes. Los datos se ingieren, procesan y almacenan tan pronto como se generan para la toma de decisiones en tiempo real. El objetivo es mantener al mínimo el retraso entre la generación y el procesamiento de datos.

Para ingerir datos en tiempo real, las empresas pueden utilizar plataformas de ingestión de datos en streaming que recopilan y procesan datos continuamente. Por ejemplo, los datos adquiridos de una red eléctrica deben supervisarse constantemente para identificar problemas, como sobrecalentamiento o mal funcionamiento del equipo, y permitir el mantenimiento preventivo para garantizar un suministro de energía continuo.

La ingesta por lotes implica recopilar y mover datos en lotes discretos. Con frecuencia, estos lotes están programados para ejecutarse automáticamente o se activan en función de un evento. La ingesta por lotes también incluye técnicas como la ingesta basada en archivos, donde los datos se recopilan de archivos (por ejemplo, CSV, JSON, XML) y se almacenan en sistemas de archivos o se accede a ellos a través de API. Es adecuado para grandes volúmenes de datos y puede procesarse de manera eficiente en intervalos programados.

Introducida por Nathan Marz en 2011, la arquitectura lambda equilibra las ventajas de la ingesta por lotes y en tiempo real al ejecutar las capas de procesamiento por lotes y en tiempo real en paralelo.

La arquitectura consta de tres capas principales:

- Capa por lotes: Esta capa es responsable de procesar grandes volúmenes de datos en modo por lotes. Por lo general, utiliza marcos de procesamiento distribuido como Apache Hadoop y MapReduce para manejar conjuntos de datos masivos. La capa por lotes calcula vistas completas de los datos a lo largo del tiempo, que luego se almacenan en una base de datos de servicio de capa por lotes.

- Capa de velocidad: La capa de velocidad maneja el procesamiento de datos en tiempo real. Se trata de datos que deben procesarse y analizarse de inmediato, proporcionando resultados de baja latencia. Tecnologías como Apache Storm, Apache Flink o Apache Spark Streaming se utilizan comúnmente en esta capa para procesar datos de transmisión en tiempo real.

- Capa de servicio: La capa de servicio atiende consultas y proporciona acceso a los resultados generados por las capas por lotes y de velocidad. Consolida los resultados de ambas capas y proporciona una vista unificada de los datos a los usuarios finales o aplicaciones posteriores.

- Micro lotes

El microprocesamiento por lotes se sitúa entre el procesamiento por lotes tradicional y el procesamiento de streaming en tiempo real. Los datos de microlotes se procesan en lotes pequeños y de tamaño fijo a intervalos regulares, que suelen oscilar entre milisegundos y segundos.

Marco de ingesta de datos

Un marco de ingesta de datos es simplemente un sistema o plataforma diseñado para facilitar la recopilación, importación y procesamiento de grandes volúmenes de datos de diversas fuentes en un entorno de procesamiento o almacenamiento centralizado.

Los componentes clave de un marco de ingesta de datos incluyen:

- Fuentes de datos: Estos pueden ser diversos e incluir bases de datos, archivos, flujos, API, sensores, etc.

- Conectores de datos: Estos adaptadores o conectores permiten que el marco interactúe con diferentes tipos de fuentes de datos.

- Transporte de datos: Esto podría implicar procesamiento por lotes, transmisión en tiempo real o una combinación de ambos.

- Manejo y monitoreo de errores: El marco debe proporcionar mecanismos para manejar errores durante el proceso de ingesta y garantizar la integridad de los datos.

- Escalabilidad y rendimiento: Un buen marco de ingesta de datos debería poder manejar grandes volúmenes de datos y escalar horizontalmente.

- Seguridad: El marco debe incluir funciones de autenticación, autorización, cifrado y cumplimiento de las normas de protección de datos.

Beneficios de la ingestión de datos

La ingesta de datos ofrece numerosos beneficios a las organizaciones. Por ejemplo, a un alto nivel, permite a una empresa tomar mejores decisiones que optimizan las campañas de marketing, desarrollan productos superiores y mejoran el servicio al cliente. Estos son los beneficios clave de la ingesta de datos:

- Recopilación de datos eficiente: La ingesta de datos permite la recopilación eficiente de datos sin procesar de diversas fuentes.

- Centralización de datos: Facilita centralización de datos en un único repositorio o sistema, lo que facilita su administración y consumo.

- Información en tiempo real: La ingesta en tiempo real facilita la obtención de información oportuna y agiliza las decisiones basadas en datos.

- Integración con herramientas de análisis: Los datos ingeridos se pueden integrar perfectamente con diversas herramientas de análisis y visualización para análisis, informes e inteligencia empresarial avanzados.

- Eficiencia operacional: La automatización de los procesos de ingesta de datos reduce el esfuerzo manual y mejora la eficiencia operativa, liberando recursos para tareas más estratégicas.

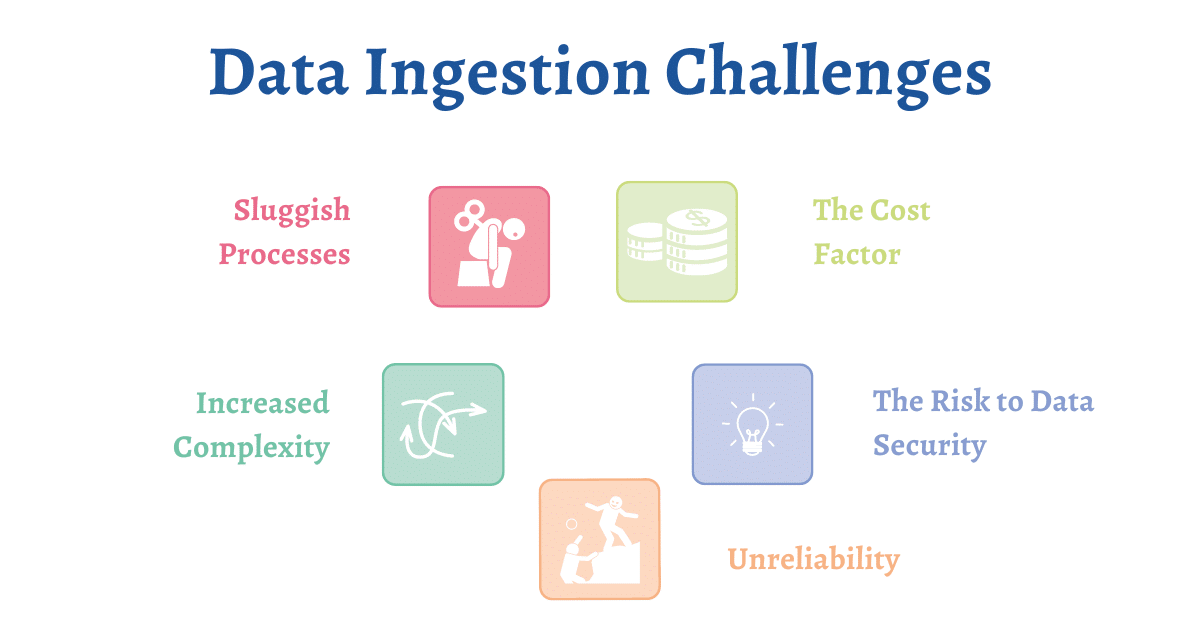

Desafíos de ingesta de datos

Desafíos asociados con la ingestión de datos

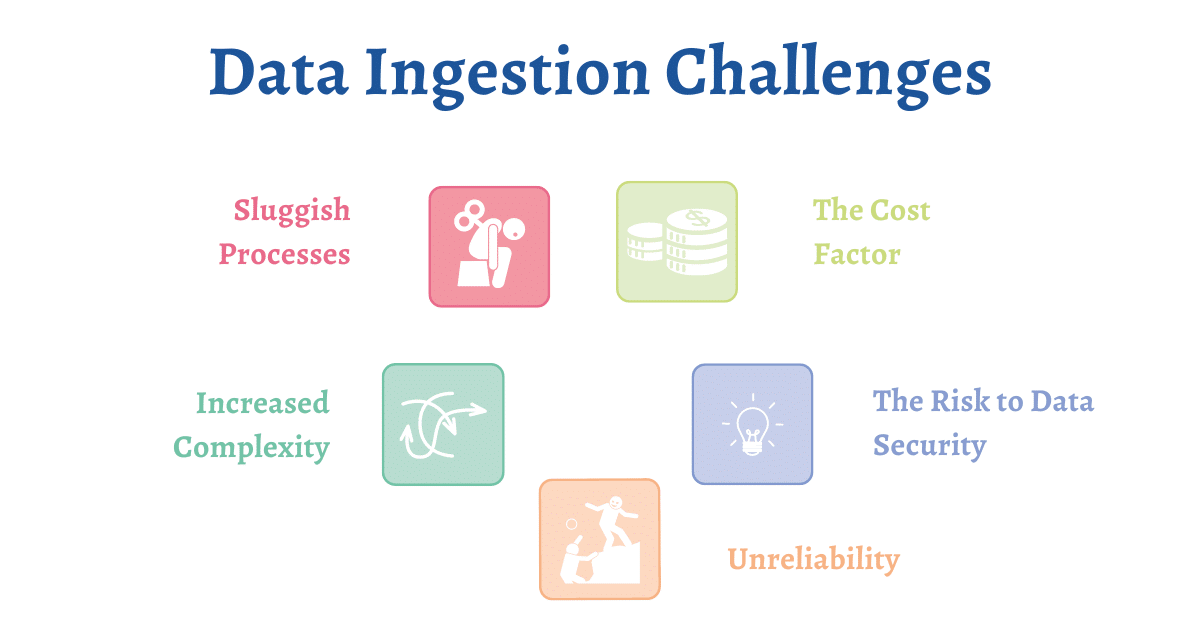

Los siguientes son los desafíos clave que pueden afectar el rendimiento del proceso de ingesta de datos:

Los datos han crecido en volumen y se han vuelto altamente diversificados. Los antiguos procedimientos de ingesta de datos ya no son lo suficientemente rápidos para perseverar con el volumen y la variedad de diferentes fuentes de datos. Y escribir códigos para ingerir datos y crear manualmente mapeos para extracción, constante, y cargarlo en la era de la automatización es un paso en la dirección equivocada.

Por lo tanto, existe la necesidad de automatizar la ingesta de datos para acelerar el proceso; utilizar una herramienta avanzada de ingesta de datos es una forma de hacerlo.

La ingesta de datos puede resultar costosa debido a varios factores. Por ejemplo, la infraestructura que necesita para respaldar las fuentes de datos adicionales y las herramientas patentadas puede resultar muy costosa de mantener a largo plazo.

De manera similar, retener un equipo de científicos de datos y otros especialistas para respaldar el proceso de ingesta de datos también resulta costoso.

- El riesgo para la seguridad de los datos

La seguridad de los datos es uno de los desafíos más importantes al incorporar y mover datos. Esta importancia se debe a que los datos a menudo se organizan en numerosas fases a lo largo del proceso de ingesta, lo que dificulta cumplir requisitos de conformidad.

- Falta de fiabilidad de malos datos

Garantizar datos limpios y precisos durante todo el proceso de ingesta es un desafío importante, especialmente para organizaciones con cientos de fuentes de datos. La ingesta incorrecta de datos puede dar lugar a análisis poco fiables y conclusiones engañosas.

Mejores prácticas de ingestión de datos

La ingesta de datos conlleva su propio conjunto de desafíos. Sin embargo, incorporar las mejores prácticas en el proceso general ayuda a abordarlas. Estas son algunas de las mejores prácticas de ingesta de datos a considerar:

Anticipe las dificultades y planifique en consecuencia

El primer paso de una estrategia de ingesta de datos sería describir los desafíos asociados con las dificultades de su caso de uso específico y planificarlos en consecuencia. Por ejemplo, identifique los sistemas fuente a su disposición y asegúrese de saber cómo extraer datos de estas fuentes. Alternativamente, puede adquirir experiencia externa o utilizar una solución sin código. herramienta de ingesta de datos para ayudar con el proceso.

Automatizar el proceso

A medida que los datos crecen en volumen y complejidad, ya no es posible confiar en técnicas manuales para seleccionar una cantidad tan enorme de datos no estructurados. Por lo tanto, considere automatizar todo el proceso para ahorrar tiempo, aumentar la productividad y reducir los esfuerzos manuales.

Por ejemplo, desea ingerir datos de un archivo delimitado almacenado en una carpeta, limpiarlo y transferirlo al servidor SQL. Este proceso debe repetirse cada vez que se coloca un archivo nuevo en la carpeta. El uso de una herramienta de ingesta de datos que pueda automatizar el proceso mediante activadores basados en eventos puede optimizar todo el ciclo de ingesta.

Además, la automatización ofrece los beneficios adicionales de coherencia arquitectónica, gestión consolidada, seguridad y gestión de errores. Todo esto eventualmente ayuda a disminuir el tiempo de procesamiento de datos.

Validación de datos y garantía de calidad

Priorice la validación de datos y las medidas de garantía de calidad para garantizar que los datos ingeridos sean precisos, completos y consistentes. Implemente controles de validación y técnicas de elaboración de perfiles de datos para identificar anomalías, errores o inconsistencias en los datos entrantes. Al validar los datos en el punto de ingesta, las organizaciones pueden evitar la propagación de errores a lo largo del proceso de datos y mantener la integridad de sus activos de datos.

Herramientas de ingesta de datos

Las herramientas de ingesta de datos son fundamentales para automatizar y acelerar la recopilación, el procesamiento y el almacenamiento de grandes volúmenes de datos de diversas fuentes. Estas herramientas agilizan el flujo de trabajo de ingesta al proporcionar conectores o adaptadores para diversas fuentes de datos, lo que elimina la necesidad de un código de integración personalizado. Facilitan el movimiento eficiente de datos a través del procesamiento por lotes, la transmisión en tiempo real o ambos, aprovechando el procesamiento paralelo y las técnicas de computación distribuida para optimizar las velocidades de transferencia y minimizar la latencia.

Además, estas herramientas ofrecen escalabilidad y rendimiento al escalarse horizontalmente para manejar cargas de datos cada vez mayores, manteniendo un rendimiento y confiabilidad consistentes incluso en escenarios de alta demanda.

Las capacidades de monitoreo y administración también son parte integral de las herramientas de ingesta de datos, ya que brindan visibilidad del proceso de ingesta y permiten a las organizaciones rastrear el estado del trabajo, monitorear el estado del sistema y solucionar problemas en tiempo real.

Además, las herramientas de ingesta de datos priorizan la seguridad y el cumplimiento, ofreciendo características como cifrado, controles de acceso y cumplimiento de las normas de protección de datos para garantizar que los datos permanezcan seguros durante todo el proceso de ingesta. Las herramientas de ingesta de datos populares incluyen Astera, Apache Kafka, Apache NiFi, Amazon Kinesis, Google Cloud Dataflow, Apache Flume y StreamSets.

Envolver

Ahora comprende lo que significa la ingesta de datos y cómo las herramientas de ingesta de datos ayudan a optimizar la gestión de datos. Estas herramientas pueden ayudar con la toma de decisiones comerciales y mejorar la inteligencia empresarial. Reducen la complejidad de reunir datos de múltiples fuentes y le permiten trabajar con varios tipos de datos y esquemas.

Para empresas que buscan una solución integral de ingesta de datos, Astera es una elección líder. Astera ofrece una plataforma potente y sin código con funciones avanzadas para conectividad, movimiento de datos y transformaciones de datos prediseñadas. Con Astera, las organizaciones también obtienen soporte al cliente galardonado y amplia capacitación y documentación.

¿Listo para experimentar de primera mano los beneficios de la ingesta fluida de datos? Regístrese para un prueba gratuita de 14 ¡hoy!